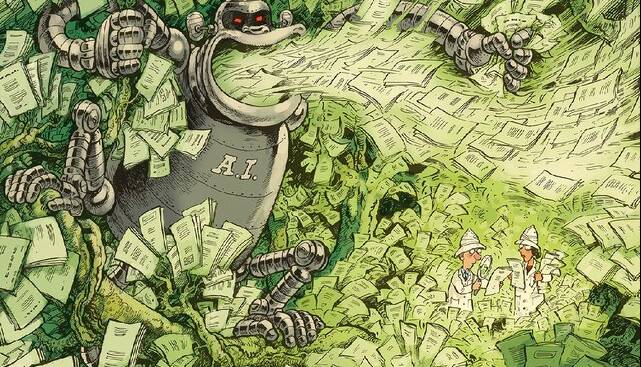

نقش هوش مصنوعی در مرور و راستیآزمایی مطالعات

علمي

بزرگنمايي:

پیام خوزستان - ایسنا / دانشمندان به این سوال که آیا هوش مصنوعی مرور مقالات و مطالعات را تسریع میکند یا آن را کاملاً مختل میکند، پاسخ دادهاند.

انتشار تعداد فزایندهای از مقالات مشکلساز از جمله مقالات جعلی تولید شده توسط هوش مصنوعی، یک بحران برای روش تثبیت شده ترکیب شواهد محسوب میشود، اما با رویکردی جدید، هوش مصنوعی نیز ممکن است نجاتدهنده این موضوع باشد.

بازار ![]()

روش ترکیب شواهد در چند دهه گذشته، پزشکی و سایر زمینهها را به میزان قابل توجهی افزایش داده است. فرآیند نظاممند ترکیب یافتههای مطالعات متعدد در مرورهای جامع به دانشمندان و سیاستگذاران کمک میکند تا از مقالات جهانی بینشهایی به دست آورند. هوش مصنوعی نویدبخش، تسریع بخشهایی از فرآیند از جمله جستجو و فیلتر کردن است. این سامانه همچنین میتواند به دانشمندان در شناسایی مقالات مشکلساز کمک کند.

اما سایر کاربردهای بالقوه هوش مصنوعی به این معنی است که بسیاری از رویکردهای در حال توسعه برای اطمینان از اینکه ترکیب شواهد، قابل اعتماد و پاسخگو باقی میمانند، کافی نخواهند بود. در واقع، دانشمندان نگرانند که استقرار هوش مصنوعی برای تولید مقالات جعلی، بحران وجودی برای این رشته ایجاد کند. آنچه مورد نیاز است یک رویکرد کاملاً متفاوت است، رویکردی که بتواند به بهروزرسانی و پسگیری مقالات در طول زمان را پاسخ دهد.

دانشمندان شبکهای از پایگاههای داده شواهد که دائماً بهروزرسانی میشوند را پیشنهاد میکنند که توسط مؤسسات متنوعی به عنوان مجموعههای زنده میزبانی میشوند. هوش مصنوعی میتواند برای کمک به ساخت این پایگاههای داده استفاده شود و هر پایگاه داده یافتههای مربوط به یک موضوع یا موضوعات گسترده را در خود جای میدهد و منبعی برای تعداد نامحدودی مرورهای فوقالعاده سریع و قوی فردی فراهم میکند.

در حال حاضر، استاندارد طلایی برای ترکیب شواهد، مروری نظاممند است. این مرورها جامع، دقیق، شفاف و عینی هستند و هدف آنها گنجاندن هرچه بیشتر شواهد مرتبط با کیفیت بالا است. آنها همچنین از بهترین روشهای موجود برای کاهش سوگیری استفاده میکنند. بخشی از این امر با غربالگری مطالعات توسط چندین مرورگر، اعلام هرگونه معیار، پایگاه داده، اصطلاحات جستجو و غیره ممکن میشود. با این حال، این مرورها نیازمند منابع قابل توجهی هستند.

برای نویسندگان مرور، همگام شدن با تعداد فزاینده مقالات دشوار است. تخمین زده شده است که مقالات علمی از سال 1952 هر 14 سال یکبار دو برابر شده است. از آنجایی که هر مرورگر تمایل به دسترسی به نشریات مختلف دارد و پایگاههای داده به طور مداوم بهروز میشوند، مرورهای نظاممند با مشکلات تکرارپذیری مواجه هستند. علاوه بر این، بسیاری از مرورهای نظاممند ناخواسته به نشریاتی استناد میکنند که پس گرفته شدهاند، از جمله مواردی که به دلیل مسائل روششناختی یا اخلاقی و کلاهبرداری از ادبیات حذف شدهاند.

دانشمندان موافقند که هوش مصنوعی میتواند بخشی از راهحل این مشکلات باشد. این میتواند به آنها کمک کند تا مرورها را جامعتر و کارآمدتر انجام دهند، اما به نظر میرسد یک جنبه نادیده گرفته شده است؛ جنبهای که هوش مصنوعی به ویژه «مدلهای زبان بزرگ»(LLMs) میتواند برخی از مشکلات را تشدید کند. در این مرحله، اطلاعات کمی در مورد اینکه چند مقاله علمی که کاملاً توسط هوش مصنوعی تولید شدهاند در حال انتشار هستند، وجود دارد.

حتی اگر «LLM ها» به طور گسترده مورد استفاده قرار گیرند، جدا کردن مواردی که در آنها برای ساخت مقالات استفاده شدهاند از مواردی که نویسندگان از آنها برای بهبود نوشتن خود استفاده میکنند، دشوار است. با این حال، هوش مصنوعی مولد احتمالاً تولید دستنوشتههای جعلی را آسانتر میکند. استفاده از چندین «LLM» تشخیص اثرات متنی مرتبط را برای انسانها دشوارتر میکند. به عبارت دیگر، استفاده از هوش مصنوعی مولد احتمالاً مشکل رو به رشد کارخانههای مقاله را تقویت خواهد کرد، با توجه به اینکه مقالات جعلی اکنون در عرض چند دقیقه به صورت رایگان تولید میشوند.

چه باید کرد؟

دانشمندان در حال حاضر دستورالعملهایی را در مورد نحوه شناسایی مطالعاتی که نگرانیهایی را مطرح کردهاند یا پس گرفته شدهاند، ارائه میدهند. این امر، شامل بررسی مطالعات در برابر پایگاه داده «Retraction Watch» است که پسگیریهای جمعآوری شده از وبسایتهای ناشران را فهرست میکند و استفاده از پایگاه داده «CENTRAL» که مخزنی برای گزارشهای کارآزمایی بالینی است ؤ مطالعات پس گرفته شده را نشانگذاری میکند.

حتی در حال حاضر نیز این نوع بررسی مجدد، اغلب اتفاق نمیافتد، احتمالاً به این دلیل که نویسندگان مرور اصلی، منابع محدودی دارند و انگیزه کمی دارند. توانایی دانشمندان با افزایش روزافزون تولید مقاله علمی، هم مشروع و هم جعلی برای حفظ تصویر دقیقی از آنچه دادهها نشان میدهند احتمالاً از بین خواهد رفت. بنابراین چه سامانهای میتواند حذف مداوم و سریع مقالات جعلی یا مشکلساز دیگر را از پایگاههای داده امکانپذیر کند؟

کار پژوهشگران بر روی پروژه شواهد حفاظتی، آنها را متقاعد کرده است که شبکهای از پایگاههای داده شواهد که با هوش مصنوعی فعال است و دائماً بهروز میشوند، یک راهحل در دسترس است.

لینک کوتاه:

https://www.payamekhuzestan.ir/Fa/News/1119244/